-

LINUX RAID1 디스크에 OS 설치하는 방법System of Infra/Linux System 2022. 4. 26. 21:57728x90반응형

LINUX RAID 1 디스크에 OS 설치하는 방법

▶ RAID1_LINUX의 Mashine 생성을 한 후 Edit virtual machine settings를 클릭합니다.

▶ 20GB 용량의 물리적 디스크 두 개를 준비해주도록 합니다. SCSI, NVme 형태는 상관없습니다.

▶ CD/DVD(SATA) Auto detect의 Connection에 설치할 Linux iso이미지를 추가해주도록 합니다.

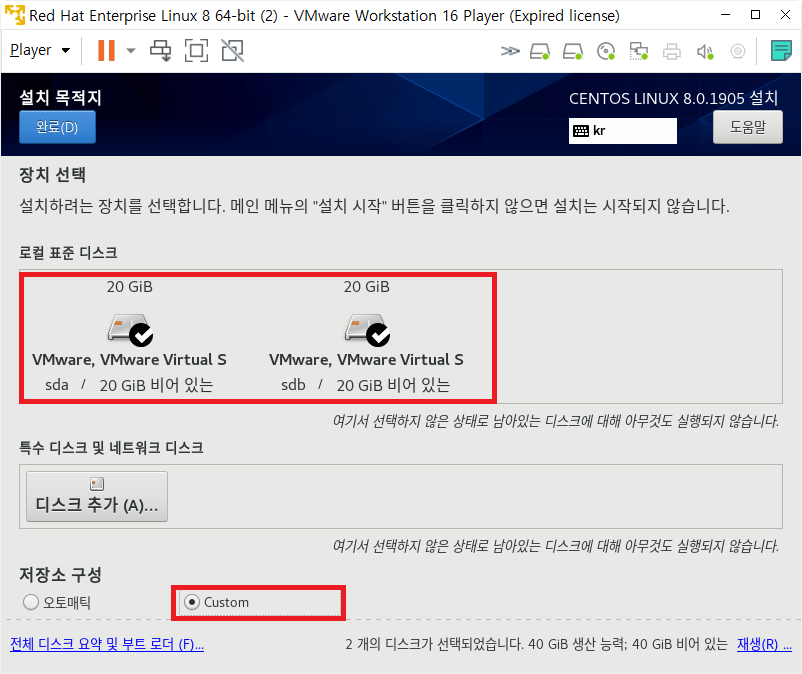

▶ 추가된 디스크 20GB + 20GB를 클릭한 후 Custom으로 설정을 합니다.

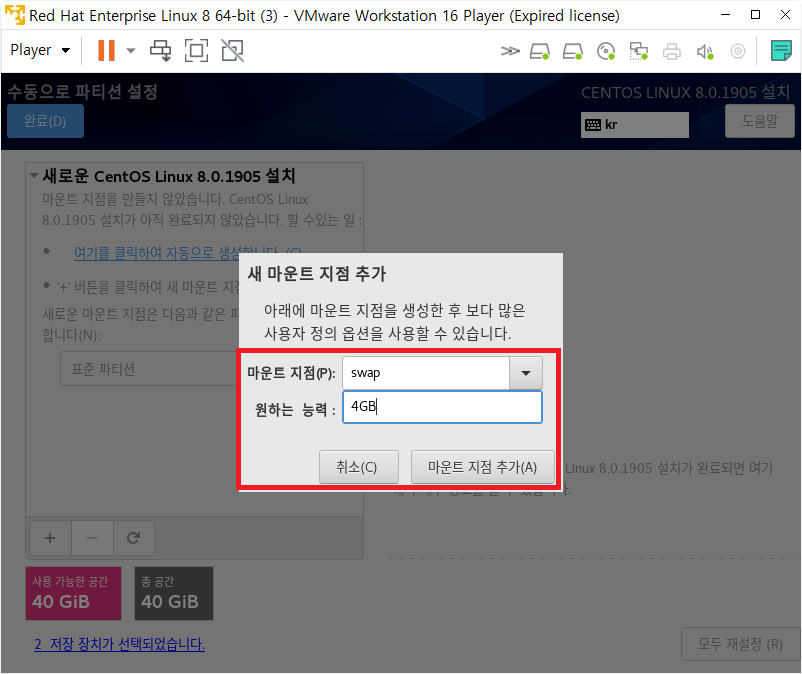

▶ 설치할 OS를 표준 파티션 항목을 선택합니다.

▶ 표준 파티션으로 지정이 완료되면 가장 먼저 swap의 영역을 지정해주도록 합니다. 20GB의 RAID 1으로 구성이 되었기 때문에 임의로 Swap의 영역을 4GB를 설정해주도록 합니다.

▶ SWAP 영역이 4GB가 생성된 것을 확인하였고 RAID로 구성을 하기 위해서 RAID 1 형태를 설정 후 설정 업데이트를 클릭합니다.

▶ ROOT의 영역을 74.93 GiB를 할당하기 전 시스템에 필요한 데이터 영역을 생성할 수 있습니다. nmon로그 수집을 위해서 nmon의 영역을 임의로 1GB를 주었고 나머지를 /영역에 할당을 합니다. 마찬가지로 장치 유형을 RAID로 설정 후 RAID 레벨을 RAID 1으로 설정 후 설정 업데이트를 진행합니다.

설정이 완료되었으면 변경 사항 적용을 통해서 RAID 1의 형태로 디스크 포맷을 진행하도록 합니다. 이후 부팅을 진행해주도록 합니다.[root@localhost /]# fdisk -l Disk /dev/sda: 20 GiB, 21474836480 bytes, 41943040 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disklabel type: dos Disk identifier: 0x1220d52e Device Boot Start End Sectors Size Id Type /dev/sda1 2048 6291455 6289408 3G fd Linux raid autodetect /dev/sda2 * 6291456 37748735 31457280 15G fd Linux raid autodetect /dev/sda3 37748736 41943039 4194304 2G 83 Linux Disk /dev/sdb: 20 GiB, 21474836480 bytes, 41943040 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disklabel type: dos Disk identifier: 0x520dd874 Device Boot Start End Sectors Size Id Type /dev/sdb1 2048 6291455 6289408 3G fd Linux raid autodetect /dev/sdb2 * 6291456 37748735 31457280 15G fd Linux raid autodetect Disk /dev/md127: 15 GiB, 16096690176 bytes, 31438848 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disk /dev/md126: 3 GiB, 3217031168 bytes, 6283264 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes▶ 설정이 완료된 이후 부팅이 완료되면 md127, md126 디스크로 15GB(root),3GB(swap)의 영역이 생성되게 됩니다. fdisk -l의 명령어를 통해서 /dev/sda1, /dev/sda2의 경우 raid 형태로 구성이 되어 있는 부분도 확인이 가능합니다.

[root@localhost /]# lsblk NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT sda 8:0 0 20G 0 disk ├─sda1 8:1 0 3G 0 part │ └─md126 9:126 0 3G 0 raid1 [SWAP] ├─sda2 8:2 0 15G 0 part │ └─md127 9:127 0 15G 0 raid1 / └─sda3 8:3 0 2G 0 part /nmon sdb 8:16 0 20G 0 disk ├─sdb1 8:17 0 3G 0 part │ └─md126 9:126 0 3G 0 raid1 [SWAP] └─sdb2 8:18 0 15G 0 part └─md127 9:127 0 15G 0 raid1 / sr0 11:0 1 6.7G 0 rom /run/media/user/CentOS-8-BaseOS-x86_64▶ lsblk의 명령어를 통해서 /SWAP, /의 영역이 RAID 1으로 구성되어 있는 것을 확인할 수 있고 md126,127로 생성이 된 것을 확인할 수 있습니다.

[root@localhost /]# df -Th Filesystem Type Size Used Avail Use% Mounted on devtmpfs devtmpfs 889M 0 889M 0% /dev tmpfs tmpfs 904M 0 904M 0% /dev/shm tmpfs tmpfs 904M 9.7M 894M 2% /run tmpfs tmpfs 904M 0 904M 0% /sys/fs/cgroup /dev/md127 xfs 15G 4.0G 11G 27% / /dev/sda3 xfs 2.0G 47M 2.0G 3% /nmon tmpfs tmpfs 181M 20K 181M 1% /run/user/42 /dev/sr0 iso9660 6.7G 6.7G 0 100% /run/media/user/CentOS-8-BaseOS-x86_64 tmpfs tmpfs 181M 3.5M 178M 2% /run/user/0▶ df-Th명령어를 통해서 data영역으로 생성했던 /nmon의 경우 2GB의 할당이 된것을 확인할 수 있습니다.

[root@localhost /]# mdadm --detail --scan ARRAY /dev/md/root metadata=1.2 name=localhost:root UUID=528f8681:8e1c7fc3:04b3173a:50d739dc ARRAY /dev/md/swap metadata=1.2 name=localhost:swap UUID=43da8f9f:72a8bc43:64855b75:20a8b310▶ mdadm --detail --scan을 통해서 RAID 1을 확인하게 되면 /ROOT, /SWAP의 RAID 형태를 확인할 수 있습니다.

[root@localhost slaves]# mdadm --detail /dev/md/root /dev/md/root: Version : 1.2 Creation Time : Thu Apr 21 17:29:18 2022 Raid Level : raid1 Array Size : 15719424 (14.99 GiB 16.10 GB) Used Dev Size : 15719424 (14.99 GiB 16.10 GB) Raid Devices : 2 Total Devices : 2 Persistence : Superblock is persistent Intent Bitmap : Internal Update Time : Thu Apr 21 17:51:33 2022 State : clean Active Devices : 2 Working Devices : 2 Failed Devices : 0 Spare Devices : 0 Consistency Policy : bitmap Name : localhost:root UUID : 528f8681:8e1c7fc3:04b3173a:50d739dc Events : 107 Number Major Minor RaidDevice State 0 8 2 0 active sync /dev/sda2 1 8 18 1 active sync /dev/sdb2 [root@localhost slaves]# mdadm --detail /dev/md/swap /dev/md/swap: Version : 1.2 Creation Time : Thu Apr 21 17:29:12 2022 Raid Level : raid1 Array Size : 3141632 (3.00 GiB 3.22 GB) Used Dev Size : 3141632 (3.00 GiB 3.22 GB) Raid Devices : 2 Total Devices : 2 Persistence : Superblock is persistent Update Time : Thu Apr 21 17:50:30 2022 State : clean Active Devices : 2 Working Devices : 2 Failed Devices : 0 Spare Devices : 0 Consistency Policy : resync Name : localhost:swap UUID : 43da8f9f:72a8bc43:64855b75:20a8b310 Events : 18 Number Major Minor RaidDevice State 0 8 1 0 active sync /dev/sda1 1 8 17 1 active sync /dev/sdb1▶ mdadm --detail /dev/md/root와 mdadm--detail/dev/md/swap의 경우 RAID 1의 형태로 active sync의 형태가 보이는 것을 확인할 수 있습니다.

[root@localhost /sys/block/md126/slaves]# ls -ltr lrwxrwxrwx. 1 root root 0 4월 21 17:48 sdb1 -> ../../../../pci0000:00/0000:00:10.0/host4/target4:0:1/4:0:1:0/block/sdb/sdb1 lrwxrwxrwx. 1 root root 0 4월 21 17:48 sda1 -> ../../../../pci0000:00/0000:00:10.0/host4/target4:0:0/4:0:0:0/block/sda/sda1 [root@localhost /sys/block/md127/slaves]# ls -ltr lrwxrwxrwx. 1 root root 0 4월 21 17:49 sdb2 -> ../../../../pci0000:00/0000:00:10.0/host4/target4:0:1/4:0:1:0/block/sdb/sdb2 lrwxrwxrwx. 1 root root 0 4월 21 17:49 sda2 -> ../../../../pci0000:00/0000:00:10.0/host4/target4:0:0/4:0:0:0/block/sda/sda2▶ ROOT영역의 디스크 디바이스가 어떤 것을 사용했는지 /sys/block/md126/slaves에서 확인할 수 있습니다.

2022.03.30 - [System of Infra/LINUX] - LINUX DISK Linear RAID 구성하는 방법(1편)

LINUX DISK Linear RAID 구성하는 방법(1편)

LINUX DISK Linear RAID 구성하는 방법(1편) [root@localhost dev]# ls -al sd* brw-rw---- 1 root disk 8, 0 3월 20 17:41 sda brw-rw---- 1 root disk 8, 1 3월 20 17:41 sda1 brw-rw---- 1 root disk 8,..

pinetreeday.tistory.com

2022.04.05 - [System of Infra/LINUX] - LINUX DISK RAID0 RAID1 RAID5 구성하는 방법(2편)

LINUX DISK RAID0 RAID1 RAID5 구성하는 방법(2편)

LINUX DISK RAID 0 RAID 1 RAID 5 구성하는 방법(2편) [root@localhost dev]# ls -al | grep sd brw-rw---- 1 root disk 8, 0 3월 20 17:59 sda brw-rw---- 1 root disk 8, 1 3월 20 17:59 sda1 brw-rw---- 1 roo..

pinetreeday.tistory.com

PS. 포스팅의 내용은 제 기준으로 작성한 것이기 때문에 참고해서 보시면 감사하겠습니다.

포스팅 과정의 오류 및 오타 그리고 궁금한 점에 대해서는 댓글 남겨주세요.

728x90반응형'System of Infra > Linux System' 카테고리의 다른 글

LINUX SSH 서버 구축 하는 방법 [원격지 서버 2편] (2) 2022.05.18 LINUX Telnet 서버 구축 하는 방법 [원격지 서버 1편] (2) 2022.05.17 LINUX LVM(Logical Volume Managemant) 구성하는 방법 (1) 2022.04.26 LINUX DISK RAID0 RAID1 RAID5 장애 긴급 복구 하는 방법 (4) 2022.04.07 LINUX DISK RAID0 RAID1 RAID5 구성하는 방법(2편) (4) 2022.04.05